normal RV做linear transformation t仍然是一個normal RV

這個很好理解,因為normal RV X是standard normal Z經過linear transformation t1,但如果combine t1和t成一個單一的linear transformation,則可以產生另一個normal RV Y,則Y事實上也是X經過t轉換之後的normal RV,故成立。

假設經過Y為X的linear transformation結果:

Y =

E(Y) =

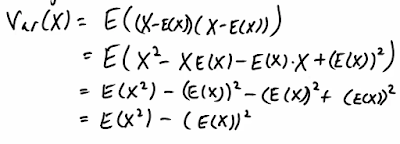

Var(Y) =

sum of Independent Normal RVs is also a Normal RV

注意:前提是independent!!!

如果X1, X2, .... Xn都是normal RV,則X = X1+X2+ .... + Xn 也是一個normal RV。

這個應該可以簡單證明,但是老師沒證,就當個先驗知識吧!

E(X) = E(X1+X2+..) = E(X1) + E(X2) + .. E(Xn) = miuX1 + miuX2 + .... + miuXn

Var(X) = Var(X1 + X2 + ... ) = Var(X1) + Var(X2) + ... = (sigmaX1)^2 + ... + (sigmaXn)^2

SD(X) =

所以這個X 要怎麼轉變成Z? 我們前面已經知道Z = (X - meanX)/sigmaX,所以Z =

也沒必要特別記啦,如果算出mean和sigma,就可以算了。

特例:當independent Xi都是有一樣的probability distribution

意即mean / sigma都一樣,則用Xi來表示Z =

範例1: 簡單查表

X1,X2, ... X100皆為同樣probability distribution的independent normal RV,mean = 3 and variance = 5。求P(X1+...+X100 <= 313)?

這是標準的找CDF table值的題目,所以我們要先把X = SUM(Xi)轉換成Z:

P(X1+X2+...+X100 <= 313)

= P(X <= 313)

= P( (X - miuX) / sigmaX) <= (313 - miuX) /sigmaX )

miuX = 100 * 3 = 30

sigmaX = sqrt(100*5)

所以P(X <= 313)

= P( Z <= 313 - 300 / sqrt(500) )

= P( Z <= 0.58)

= 0.7190 /* 查表 */

範例2: 找出threshold a使得X的機率 <= 已知數

independent normal RV X1,X2, ... ,X150 , 有E(Xi) = 3.5, var(Xi) = 1.2,找出P(X1+X2+...+X150 <= a) ~= 0.9 ?

這個題目是反過來,知道CDF值,求a。

X = X1+X2+ .. + X150

E(X) = 3.5*150

SD(X) = sqrt( 1.2*150 )

P(X <= a) = P(Z <= a - E(X) / SD(X)) = 0.9

我們查表可以知道P(Z <= 1.28 ) =0.8997

所以 a - E(X) / SD(X) = 1.28

a = 542.17

這語意為“90% of the time that X is <= 542.17”

範例3:找出x interval使得X落在此interval的機率 <= 已知數

承上題,找出一個interval of x[miuX-a, miuX+a],中心點為X的mean,

使得P(miuX-a <= X <= miuX+a) ~= 0.8?

上題中我們已經得到以下的區間的機率:

而且已知P(X <= 525) = 0.5,為什麼?因為525是mean,而且X是一個normal RV,density是對稱於mean的。

所以P( mean <= X <= 542.17 ) = 0.9 - 0.5 = 0.4

所以其實我們早就找到了a = 542.17 - 525(其實是老師設計的好)

範例4:不同probability distribution的Xi Yi時

這其實沒什麼不同,因為我們前三題算的其實是特例,但是通例我們也知道怎麼算,在

“sum of Independent Normal RVs is also a Normal RV”

小節中,就告訴我們了。

所以假設independent Xi的mean = 1.6, variance = 2.2,而independent Yi mean = 3, variance = 2.3

則X = Xi + Yi,P(X < 400) =

X, Y為independent normal RV,則X - Y也是一個normal RV,為何?

因為-Y是Y做-1倍的scaling,所以-Y是一個normal RV,

所以X + (-Y) 是一個normal RV,因為我們前面已經說過一堆independent normal RV的和仍然是一個normal RV。

-Y的mean = E(-Y) = -E(Y) = -mean of Y

-Y的variance = var(-Y) = (-1)^2 * var(Y) = variance of Y = (sigmaY)^2

所以X-Y的 mean = meanX + mean(-Y) = miuX - miuY

var(X-Y) = (sigmaX)^2 + (sigmaY)^2

例如: