Project定義

"A project is a temporary endeavor undertaken to create a unique product, service, or result."所以一個project是:

1. 有期效性

2. 產出結果 (deliverable)

所以project management就是在預定期限內,得到project結果的方法與工具組合。

Project Objective

1. scope: 達到要的程度2. time: 在預定時間內

3. cost:在預算內

這三個要素構成一個objective,也就是目標,由於是限制性的因素,也被稱為TThe Triple Constraint。

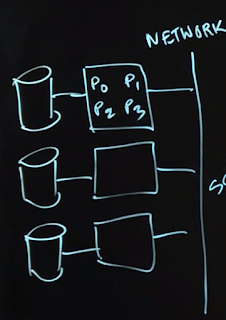

三者必須互相平衡,就像三角椅一樣:

project management skill就是要確保The Triple Constraint處於平衡狀態。

Project Life Cycle

簡單來說是以下四個phases,每個phase都會有check point 產出,一步步抵達objectives。Initiation

- 找出問題或機會

- 指派主持人和參與者

Planning

- 執行細節定義

- 時程定義

- 預算規劃

- 風險評估

- 品保規劃

Execution

- 執行

- 定期檢視檢討是否符合plan

Closing

- 合約善後

- 事後檢討

- 釋放資源

Project Manager的特質

主要還是The triple contraint的管理,人格特質上基本就是要有領導魅力,以及善於溝通和在壓力狀態下冷靜。不過這特點其實每個職業工作者都應該要有,換句話說,每個人都該有project manager的特質,也都應該是潛在的project manager。另外對risk management也必須很強大,我朋友某A是enginee),雖然參與的project成功deliver,品質與架構都非常優秀,但是這歸因於A爆肝完成,也就是the triple constraint管理徹底失衡。A發現個人責任感被充分壓榨,而其他管理者都涼涼的準時上下班,談笑風生,最後A離職了。

這是一個失敗的project management,事實上此案例中不論位階,所有管理者並沒有project management的知識與經驗,有的都是個人過往的工作慣性與土法煉鋼的方式,這證明了management是一個很需要專心學習與實踐的skill,難度不亞於學習AI或是Machine Learning (笑~)。

這個project最大的失敗在於管理者根本不知道所謂的The triple constraint,也沒有risk assessment和management。客戶不斷壓榨vendor時,vendor端的PM要想如何維護住triple constraint的平衡,必須好好思考怎麼引導客戶甚至高階經理人避免危及triple constraint平衡的可能。

要維持triple constraint的平衡,就該有tradeoff,但是本案例PM與上位管理者沒有此概念,長期把壓力施加在工程師A身上,最終導致enigneer的不滿而離職 。

同理心是PM另一個非常需要的特質,有此特質則team building與溝通能力,甚至leadership都能水到渠成。

朋友A觀察到的lesson就是: 要有同理心,而manager真的無法引導客戶或是上位經理人的壓力時,最好能用情感方式支持專案成員,例如陪伴加班是很實際的鼓舞方式,(一起吐苦水倒是不用,免得引爆辦公室政治),而研發出身的專案管理者,最好不要放棄R&D skill,能夠實際承接小部分開發工作的話,不但能夠同理超時工作身心俱疲的成員感受,也能舒緩成員工作負荷,並且增進團隊感情。